Kostenreduzierung, TCO und ROI bei Storage und Backup V1.13 (c) Stor IT Back 2025

Im Mittelstand wird ein SAN bzw. ein zentrales Storage oder ein

NAS oder Fileserver

von der Geschäftsführung häufig als viel zu teuer betrachtet.

Und Fragen wie "Brauchen wir das wirklich?" oder "Wann rentiert sich das?" treten auf. Die rein technischen Gesichtspunkte treten in den

Hintergrund. Aber auch größere Unternehmen

stehen schnell vor der Frage: Sollen wir das teure Fibre Channel nehmen oder doch lieber das vermeintlich

kostengünstige iSCSI auf 10 Gigabit? Aber das sind nicht die einzigen Fragen, wo es um Kosten geht.

Um die Gegenüberstellung von Kosten und Nutzen geht es doch immer, oder? Die EDV kostet doch nur Geld! Falsch, wenn das

so wäre, dann hätte kein Unternehmen eine EDV. Selbstverständlich hat die EDV immer auch einen Nutzen und darauf sollte sie ausgelegt werden. Viele Anwendung gäbe es ohne EDV

nicht. Einen Online-Shop kann man nur mit einer funktionieren EDV betreiben. Auch eine Bank läuft nicht mehr ohne EDV. Eigentlich selbstverständlich,

deswegen muss die EDV auch Geld kosten, aber nicht mehr als sie erwirtschaften kann.

Ein weiterer wichtiger Punkt in die Betrachtung kommt hinzu: Die Verfügbarkeit! Oder würden Sie Ihr Geld einer Bank

anvertrauen, welche nicht rund um die Uhr ihr Geld auch wieder herausgeben kann? Sicherlich nicht, aber dies gilt nicht nur für

eine Bank ... Die zusätzliche Verfügbarkeit kostet Geld, dieses Geld muss das Unternehmen aber auch durch die Verfügbarkeit erwirtschaften, wenn die Lösung passt.

Die Berechnung der Total Cost of Ownership (TCO) soll es Unternehmen ermöglichen, alle Kosten zu einer Anschaffung von Hard-

und Software aufzuzeigen. Dies ermöglicht einen unabhängigen Vergleich von verschiedenen Angeboten oder Konzepten mit allen Kosten.

Wenn zum Beispiel ein Router in der Anschaffung kostengünstiger als ein Vergleichssystem ist, aber deutlich mehr Kosten im Betrieb durch Strom und Abwärme verursacht,

dann kann der von der Anschaffung teurerer Router trotzdem insgesamt kostengünstiger sein.

Auch bei Software sollte man diese Betrachtung durchführen. Als Beispiel kann eine Backup-Software in der Lizenz (Anschaffung oder Miete) deutlich kostengünstiger

als ein Vergleichsprodukt sein, wenn es aber in der Administration umständlich zu bedienen ist, dann führt dies zu höheren Personalkosten. Auch ein Faktor im TCO.

Die TCO ist relativ einfach zu berechnen, alle Kosten zusammenzählen und schon ist die Gesamtsumme der Anschaffung ermittelt.

Der ROI (Return on Investment) wird im allgemeinen mit Gewinn durch Gesamtkapital berechnen. Bei einer Einzelanschaffung mit Gewinnanteil durch Kapitaleinsatz.

Also den einen Faktor in der Berechnung haben wir ja schon, der Kapitaleinsatz ist ja unsere TCO für die Anschaffung. Aber was ist mit dem Gewinnanteil? In der Praxis ist dieser

Wert meist nur schätzbar, also was würde passieren, wenn die Anschaffung nicht durchgeführt wird? Ein einfaches Beispiel: Ein Unternehmen nur mit einem Webshop kauft einen neuen

Webserver. Wie ist der Gewinn aus dieser Anschaffung? Na ja, ohne Webserver kein Webshop und damit keine Geschäfte für das Unternehmen. Also fällt dann doch der gesamte Gewinn auf den

Webserver? So einfach ist es auch wieder nicht, was ist mit dem Einkauf, dem Vertrieb? Und damit haben wir ein Problem, welcher Gewinn fällt auf eine Anschaffung? Meist kann man

es nicht mal annähernd genau bestimmen. Und dann kommt der Spruch: Ging ja früher auch ohne EDV. Damit kostet die EDV nur Geld und macht ja kein Gewinn. Falsch, der Gewinn muss nur

richtig ermittelt werden. Und wenn das gelingt, macht die Bewertung einer Anschaffung über den ROI auch Sinn.

Bei der Amortisationszeit geht man noch weiter. Wie schnell amortisiert sich die Anschaffung. Also ab wann macht man mit dem neuen System einen Gewinn. Warum ist der Faktor Zeit so wichtig?

Gerade die Hardware in der Investition hat eine gewisse Laufzeit, bzw eine Lebensdauer. Die Lebensdauer wird zum Beispiel durch die Verfügbarkeit von Ersatzteilen oder einfach der Laufzeit

eines Wartungs- und Servicevertrages bestimmt. Bekomme ich keinen Support mehr für die Hardware, dann wird ein Betrieb der Lösung riskant. Ein kleiner Ausfall kann dann zum Totalausfall werden.

Damit sollte man den ROI bzw. die Amortisation immer auch im zeitlich Verlauf sehen und betrachten.

Was dieses Bild links verdeutlichen soll: Die Hardwarekosten werden genau betrachtet,

berechnet und abgewogen. Auch Kosten für Wartung und Software lassen sich

gut in Zahlen fassen, die Hard-Facts sind bekannt und werden optimiert. Bei

den Soft-Facts ist das anders, erstens sind sie schwer zu ermitteln und zweitens

schwerer zu bewerten.

Es sind zum einen die Mitarbeiter, je komplexer und umfangreicher die IT-Umgebung wird, desto mehr Mitarbeiter

benötigt das Unternehmen, um die EDV am Laufen zu halten. Und in der heutigen Zeit müssen schon immer weniger

Mitarbeiter immer mehr und komplexere EDV betreuen. Das schlägt sich auch in der Qualität und Verfügbarkeit der Lösungen nieder. Also lieber

etwas mehr Geld in durchdachte Hard- und Software investieren und damit die Mitarbeiter

entlasten. Sie erreichen eine bessere Verfügbarkeit in einer homogeneren Umgebung. Dies kann zum Beispiel

durch ein zentrales SAN erreicht werden, aber auch durch Virtualisierung der Server-Umgebung. Der zentrale Storage verringert den Aufwand und kann zusätzlich bei

entsprechender Dimensionierung die Verfügbarkeit und Flexibilität deutlich steigern. Denken wir nur mal an das Verschieben von virtuellen Maschinen im laufenden Betrieb,

das geht ohne ein Shared Storage überhaupt nicht. So können Server an einem Werktag gewartet werden (offline), ohne einen Ausfall zu haben.

Aber nicht nur durch die reine Hardware bzw. die redundante Auslegung von Hard- und Software, sondern speziell

auch durch eine Standardisierung und Verschlankung der Lösungen wird die Verfügbarkeit verbessert. Warum das? Ein möglicher Fehler ist schneller zu finden, die Behebung ist einfacher.

Und es passieren in übersichtlichen Umgebungen auch weniger Fehler, die Gesamtverfügbarkeit steigt merklich.

Auf der Nutzen-Seite der EDV wird es meist schwieriger zu argumentieren. Aber auch dort gibt es Zahlen: Wenn zum Beispiel

eine Geschäftsidee ohne EDV überhaupt nicht umgesetzt werden kann, dann ist es einfach. Was wirft die Idee ab und welche Kosten

müssen gedeckt werden, ein wenig Gewinn noch abziehen und Sie haben ein EDV-Budget.

Aber wenn es um das Basisgeschäft geht, wie viel darf dort die EDV kosten? Auch dort ist das Budget berechenbar.

Nehmen wir als Beispiel die Verfügbarkeit, wie hoch ist das Budget für die K-Fall Vorsorge? Hier rechnet man am einfachsten über die Ausfallzeit der EDV.

Genau die wollen wir durch die K-Fall Vorsorge verringern. Wenn zum Beispiel durch einen Brand die gesamte EDV ausfällt, wie lange dauert es dann, bis

die EDV mit den wichtigsten Anwendungen wieder online ist? Eine Woche, zwei Wochen, wie hoch ist der Datenverlust? Wie lange dauert es dann,

alles wieder auf den aktuellen Stand zu bringen? Und am wichtigsten: Gibt es das Unternehmen nach 2 Wochen ohne EDV überhaupt noch?

Jetzt kommen noch die Soft-Facts hinzu. Zum Beispiel das Image der Firma, die Zuverlässigkeit,

pünktliche Auftragsabwicklung und das Gefühl der Kunden bei einem

sicheren Lieferanten oder Dienstleister gut aufgehoben zu sein. Dieses gute Image kann schnell

zerstört werden. In unserem Beispiel gehen Kunden- und Auftragsdaten verloren, es werden Lieferungen verzögert

und im schlimmsten Falle müssen die Kunden informiert und Bestelldaten erneut abgefragt

werden. In diesem Moment sind die Kunden verunsichert, das Image leidet. Aber wie bewertet man diesen Imageverlust in Geld, in Euro? Das

kann ein Unternehmen meist nur selbst ermitteln, wir helfen gerne mit Argumenten

und Szenarien weiter.

Deswegen beschränken wir uns bei dem unten aufgeführten Beispiel auf

die Hard-Facts. Die Soft-Facts sollten aber immer im Hinterkopf behalten werden,

da sie einen großen Einfluss auf die langfristige Geschäftsentwicklung

haben.

Sie besitzen 10 Windows-Server mit je 5 lokalen Festplatten als " title="Informationen zu RAID">Raid 5 Verbund

und jeweils einer Hot-Spare-Platte. Das sind also 50 Festplatten insgesamt.

Aus dem Aufbau von RAID 5 ergibt sich in diesem Beispiel ein maximal nutzbarer

Speicherplatz von 3 Festplatten. Eine geht für die Parity-Informationen und

eine für die Hot-Spare-Platte verloren. Laut Statistik nutzen Sie diese Windows

Laufwerke nur zu 30% für Nutzdaten. Bei einer physikalischen Festplattengröße

von 300 GB (900 GB Speicherplatz pro Server in diesem Beispiel), nutzt jeder

Server 270 GB Kapazität mit Daten, gekauft wurden aber 5 x 300 GB, also 1.500

GB! Ein Nutzungsgrad von 18%.

Müssen Sie jetzt aus Mangel an Festplattenkapazität an 5 Server zusätzlich

DAS-Systeme anschließen, so dreht sich die Kostenschraube weiter. 5 Hardware-Geräte

anschaffen, jeweils wieder zusätzliche Hot Spare Platten, Überwachung

für die Systeme, usw.

Ein weiterer Faktor sind die Nebenkosten, wie Stromverbrauch, Miete und Klima.

Auch die Administrationskosten steigen mit der Anschaffung von vielen DAS-Systemen,

Wartung und Verfügbarkeit werden verschlechtert.

Nach diesen Vorgaben berechnen wir die Anschaffungskosten für das Jahr der Investition:

| 50 Festplatten (10 Server mit je 4+1 Festplatte) | 20.000 € |

| 5 DAS-Systeme zur Erweiterung inkl. 25 Platten | 35.000 € |

| Kosten im ersten Jahr | 55.000 € |

Jetzt berechnen wir alles noch einmal, die 10 Server sind aber in einem SAN. Es muss kein Server mit einem DAS erweitert werden, die 75 Einzelfestplatten (50 aus den Servern und 25 aus den DAS-Systemen) reduzieren sich bei gleichem nutzbaren Datenvolumen auf 13 Festplatten, ebenfalls in Raid 5 mit einer Hot Spare. Statt den 10 Hot-Spare-Platten wird nur noch eine benötigt. Die eine Host-Spare-Platte ist leicht zu verstehen, aber bei den 13 Festplatten wird es schwieriger. Ohne SAN wurden 270 GB pro Server wirklich genutzt, diese Menge muss natürlich auch im SAN zur Verfügung stehen. Jedoch liegt hier die Ausnutzung bei 80% (es wird weniger Reserve vorgehalten), also werden nur ca. 340 GB pro Server benötigt, also 11 Festplatten und natürlich die eine für die Parity-Informationen.

| 13 Festplatten (11 Netto + 1 Raid 5 + 1 HS) | 5.200 € |

| SAN (RAID-System, Switch, HBAs) | 30.000 € |

| Kosten im ersten Jahr | 35.200 € |

Ein einfaches Beispiel, aber wir haben nur das erste Jahr berechnet. Im zweiten Jahr machen Sie weiter Gewinn mit Ihrem neuen SAN und dies sollte ja auch jede Anschaffung erreichen! Eine Speichererweiterung eines Servers bedeutet nur noch Festplatten für das SAN nachkaufen und einstecken. Die Administration wird einfacher, es muss nur noch ein Gerät überwacht werden, Strom- und Klimakosten gehen zurück, die Speicherverwaltung wird effizienter und damit wird die TCO gesenkt.

Warum ist der Nutzungsgrad eines Laufwerkes in einem SAN anderes als bei DAS-Systemen (Storage für einen Server)

oder internen Festplatten? Dies hängt sehr entscheidend von der Flexibilität

des Speichermediums ab. Die meisten Storage-Controller im SAN beherrschen die Vergrößerung

ihrer freigegebenen Laufwerke im laufenden Betrieb. Auch das Hinzufügen von

Festplatten im laufenden Betrieb ist kein Problem. Also muss nur eine geringe

Reserve vorgehalten werden, im Notfall lässt sich ja noch einiges machen.

Aber bei internen Festplatten? Wenn es keine Hot Swap Festplatten sind, dann auch noch den Server herunterfahren, neue Festplatte einbauen,

System um konfigurieren und neu starten. Wer hat schon so viel Zeit und dann natürlich

in der Haupt-Onlinezeit.

Aber bei internen Festplatten? Wenn es keine Hot Swap Festplatten sind, dann auch noch den Server herunterfahren, neue Festplatte einbauen,

System um konfigurieren und neu starten. Wer hat schon so viel Zeit und dann natürlich

in der Haupt-Onlinezeit.

Die Flexibilität eines SAN spart nicht nur Investitionskosten, sondern auch

teure Ausfallzeiten. Aber zurück zu den Hard-Facts: Die Grafik veranschaulicht die Verhältnisse von "aktiven

Daten" zu dem gesamten Overhead.

Eine weitere Optimierung lässt sich mit einer HSM-Funktion (Hierarchical

Storage Management) erzielen. Hierbei werden lange nicht genutzte Daten auf

kostengünstige Medien verschoben. Dies spart kostbaren und schnellen Festplattenplatz.

Wird jetzt doch mal eine "alte" Datei benötigt, so wird diese

zurück auf ihren alten Platz geholt. Ein Anwender merkt wenig von einem

HSM, nur es dauert eine gewisse Zeit, bis die Datei aufgerufen werden kann.

Aber nicht nur der Plattenplatz wird eingespart, auch die Vollsicherung wird

schneller und kleiner, der Virenscanner läuft kürzer und das Gesamtsystem

wird performanter. Auch bei einer möglichen Desaster-Recovery sind HSM-Fileserver

klar im Vorteil: Es werden die wirklich auch benötigten Dateien restored,

selten genutzte oder alte Daten liegen ja auf anderen Medien.

Auch in diesem Fall: Die HSM-Software kostet in der Anschaffung natürlich

Geld, jedoch kann durch optimiertes Backup, weniger Hardwarekosten und flexiblerer

Nutzung schnell ein Gewinn erwirtschaftet werden.

Warum jetzt ein eigenes Kapitel für SSDs? SSDs sind immer noch sehr teuer,

selbst bei kleiner Kapazität ist eine SSD wesentlich teurer als eine SAS

oder gar SATA Festplatte. Unbestritten, die SSD hat die beste Performance, die

schnellste Zugriffszeit und die meisten IOs pro Sekunde. Rein technisch gesehen

hat die SSD viele Vorteile, aber wenn man größere Datenmengen auf

SSDs bekommen will, wird die Lösung auch sehr teuer.

Wenn die SSDs also sehr teuer sind, dann müssen sie wenigstens gut ausgelastet

werden. Also nur wirklich performance-relevante Daten auf die SSDs legen. Aber

wie bekommt man das hin? Normalerweise nutzt man eine LUN auf einem Plattentyp,

in diesem Beispiel eine LUN für eine Datenbank. Jetzt kann aber die Datenbank

auch aus Datensätzen bestehen, die nur selten oder gar nicht gelesen werden. Und was sollten

diese Daten auf der SSD? Die Lösung: Nur die wirklich benötigten Blöcke

kommen auf die SSDs, alle anderen auf SAS oder SATA Platten. Damit werden die

teuren SSDs maximal genutzt. Diese Technik des Verteilens der Daten auf unterschiedliche

Tiers (= Festplatten-Typen) nennt man Tiering.

| 10 SSD Platten mit je 960 GB in RAID 10 | 25.000 € |

| Storage-System ohne automatisches Tiering | 10.000 € |

| Kosten für die Anschaffung | 35.000 € |

Mit dieser Konfiguration sind ca. 4 TB in RAID 10 auf den SSDs nutzbar. Damit kann eine 4 TB Datenbank komplett auf SSDs betrieben werden. Sicherlich eine gute Performance, aber evtl. auch eine Verschwendung. Nehmen wir einmal an, dass nur 1 TB der Datenbank wirklich eine hohe Performance benötigt. Dann können wir die Anschaffungskosten folgendermaßen ansetzen:

| 2 SSD Platten mit je 960 GB in RAID 1 | 5.000 € |

| 8 SAS Platten mit je 1,2 TB in RAID 10 | 4.000 € |

| Storage-System mit automatischem Tiering | 15.000 € |

| Kosten für die Anschaffung | 24.000 € |

Selbst bei diesem einfachen Beispiel mit nur einer Datenbank bringt es eine große Einsparung in der Investition. Je mehr Systeme, Anwendungen und Datenbanken integriert werden, desto größer wird die Einsparung. Und das immer noch bei der Performance einer SSD. Aber nur dort, wo die Performance auch wirklich gebraucht wird.

Ein einfache Sprichwort macht die Sache deutlich: "Cluster kost' Zaster". Die Hochverfügbarkeit kostet Geld,

ist ja eigentlich auch logisch. Ein Cluster besteht ja aus mindestens 2 Servern, von denen eigentlich nur einer

benötigt wird. Also doppelt so viel Hardware und dann kommt auch noch die Cluster-Software dazu. In vielen Fällen

wird ein Cluster in etwa drei Mal so teurer wie ein Einzelserver.

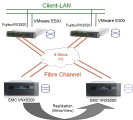

Ähnliches gilt auch beim Storage: Sie benötigen nicht

nur ein Storage-System, sondern zwei identische und dann auch noch die Replikationslizenz für beide Storage-Systeme. Das wird

jetzt nicht gleich das Dreifache sein, aber wie kann man diesen doppelten Preis mit den betrieblichen Vorteilen rechtfertigen? So einfach mit den

Hard-Facts ist es nicht mehr möglich, hier kommen die Soft-Facts zum Zuge. Aber erst einmal, was erreiche ich mit einer

Storage-Replizierung an einen zweiten Standort? Im K-Fall (der erste Standort fällt komplett aus) sind die Daten am

zweiten Standort komplett und schnell verfügbar. Je nach Art der Replikation innerhalb von wenigen Minuten oder sogar ohne merklichen

Ausfall. Und genau das brauchen Unternehmen mit sehr agiler Datenverarbeitung. Zum Beispiel ein Webshop, ist dieser nicht

erreichbar, so nutzen die Kunden einfach andere Shops im Internet. Die Kunden sind weg und kommen nie wieder, ein Ausfall von mehreren

Stunden kann einen großen Teil der Kunden zum Abwandern bringen. Also die reine Verfügbarkeit ist sehr wichtig bei diesen

Anwendungen.

Aber auch ein möglicher Datenverlust kann sehr nachteilig sein. Die Kunden haben etwas bestellt, auch eine Bestätigung vom

Shop bekommen, aber die Bestellung kommt nie an. Muss die Kundendatenbank nach einem K-Fall erst von Band restored werden, so dauert

das nicht nur lange, sondern es gehen auch alle Daten seit der letzten Sicherung verloren.

Ein Beispiel mit realen Zahlen ist schwierig zu erstellen, nehmen wir einmal einen großen Online-Anbieter als Beispiel. Ein Ausfall

von nur einem Tag kann sicherlich schon die gesamte Hochverfügbarkeit bezahlt machen, nur aus den entgangenen Umsätzen. Dann kommt aber

auch noch der Image-Schaden dazu. Wer kauft schon gerne da ein, wo die Bestellsysteme einen ganzen Tag ausfallen?

Wichtig ist in jedem Fall eine passende Beratung. Und zwar individuell auf Sie zugeschnitten, nur so können wir gemeinsam ermitteln, welche

Lösung Sie benötigen. Und dann ist die Begründung für das Budget quasi schon enthalten...

Das Backup bzw. die Datensicherung ist ein klassisches Beispiel für "das kostet doch nur Geld und bringt nichts", oder? Natürlich kostet Backup

eine Menge Geld, aber es bringt auch was. Bei einem Systemausfall oder dem absichtlichen oder unabsichtlichen Löschen können Daten

schnell wiederhergestellt werden. Da ist ja die Aufgabe der Datensicherung bzw. des Restores.

Apropos absichtliches Löschen von Daten: Um dies zu verhindern bzw. das Ausmaß zu begrenzen sollte man eine Gewaltenteilung in der EDV (gerade bei größeren Unternehmen) einführen.

Der Backup-Administrator sollte nicht gleichzeitig auch den root- oder Admin-User für alle Produktionsumgebungen besitzen. Sonst könnte er die

produktiven Daten löschen und die Backups zerstören. Damit sind dann alle Daten verloren, das Unternehmen kann aufgeben. Mindestens die

Sicherungen sollten physikalisch an einem anderen Ort gelagert werden, zu dem die EDV keinen Zugang hat. Also zum Beispiel in einem Bankschießfach oder

einem Tresor im Hause.

Und mit dem schnellen Wiederherstellen von Daten

kann man tatsächlich Geld einsparen. Das ist aber nicht so einfach zu berechnen. In diesem Fall muss der Ausfall der Systeme berechnet werden. Und

das kann sehr schnell sehr teurer werden. Nehmen wir mal einen Online-Shop: Kunden bestellen den ganzen Tag lang, zu einem bestimmten Zeitpunkt werden

die Bestellungen versandfertig gemacht und die Rechnungen geschrieben. Wenn jetzt durch einen Fehler Daten verloren gehen, dann weiß man nicht mehr,

wer was bestellt hat, was schon verschickt wurde und was noch nicht bezahlt wurde. Und wenn diese Daten wirklich weg sind, also kein

funktionierendes Backup vorhanden ist, dann sind diese Bestellungen verloren. Schlimmer noch, es kommen für durchgeführte Lieferungen evtl. keine

Zahlungseingänge, weil die Rechnungen fehlen. Das kann schnell zur Insolvenz führen. Und was sagen die potentiellen Kunden? So etwas spricht sich

schnell rum und Kunden bleiben aus. In vielen Fällen führt ein Datenverlust früher oder später in die Insolvenz.

Aber wie lassen sich dort Kosten berechnen? Der Imageschaden ist schwer zu kalkulieren (sollte aber nicht vergessen werden), aber den Ausfall pro Tag kann man schnell berechnen.

Und dann noch die Mitarbeiter, die erst nicht arbeiten können (direkt nach dem Ausfall) und später alles Aufarbeiten müssen, zum Beispiel

Kundendaten nachpflegen, Versanddaten aktualisieren, Kunden beruhigen und dadurch entstandene Fehler ausbessern. Zusammen mit dem Imageverlust

kommen auch ohne finanzielle Probleme schnell großen Summen zusammen.

Aber nicht nur Ausfälle und das unabsichtliche (oder absichtliche) Löschen von Daten benötigt eine Datensicherung. Auch bei Virenbefall ist eine professionelle

Datensicherung meist die letzte Rettung. Dabei darf das Backup nicht im normalen Zugriff liegen. Eine Kopie der Daten auf einer USB Platte ist

zwar im ersten Gedanken eine gute und kostengünstige Lösung, aber bei einem Malware-Angriff werden dann die produktiven Daten verschlüsselt und die

USB Platten gleich mit.

Wir erstellen für Sie gerne eine Kalkulation nach einer IST-Analyse Ihrer IT-Infrastruktur. Leasing kann diesen Kostenvorteil noch weiter ausbauen. Auch in diesem Themenbereich beraten wir Sie gerne. Setzten Sie sich mit uns in Verbindung.